Meta最新3D Gen模型实现60倍速生成

不管是图像还是视频,即使能做出3D效果,终究只是二维空间中的像素组成的。支持平面图转3d

Meta最近发布的3D Gen模型,则能实现1分钟内的端到端生成,从文本直出高质量3D资产。可以使平台图转3D模型。

不仅纹理清晰、形态逼真自然,而且生成速度比其他替代方案加快了3-60倍。

Meta放大招!发布3D生成最新成果——Meta 3D Gen。

号称1分钟内即可文本端到端高质量转3D,包括高质量纹理和基于PBR材质(基于物理的渲染)贴图的3D Mesh。

支持修改已有的3D对象/模型的纹理。

例如,编织风:

像素风:

单拎出来一只金属哈巴修狗,毛发纹理等各种细节拉满:

搭配其它工具装上骨架让3D模型动起来,效果也可以用“精细”两字形容:

目前,模型还没有开放试用API以及相应的代码,官方消息中也没有透露下一步的发布时间。

3D Gen模型则克服了这些困难,在领域内迈出了第一步。

模型最大的亮点在于支持基于物理的渲染(PBR,physically-based rendering),这对于在应用场景中实现3D资产的重新照明非常必要。

此外,经过专业艺术家的评估,3D Gen在生成同等质量,甚至更优内容的同时,缩短了生成时间,提升了指令跟随性能。

生成出3D对象后,模型还支持对其纹理进行进一步的编辑和定制,20s内即可完成。

方法

这种更加高效的优质生成,离不开模型pipeline的精心设计。

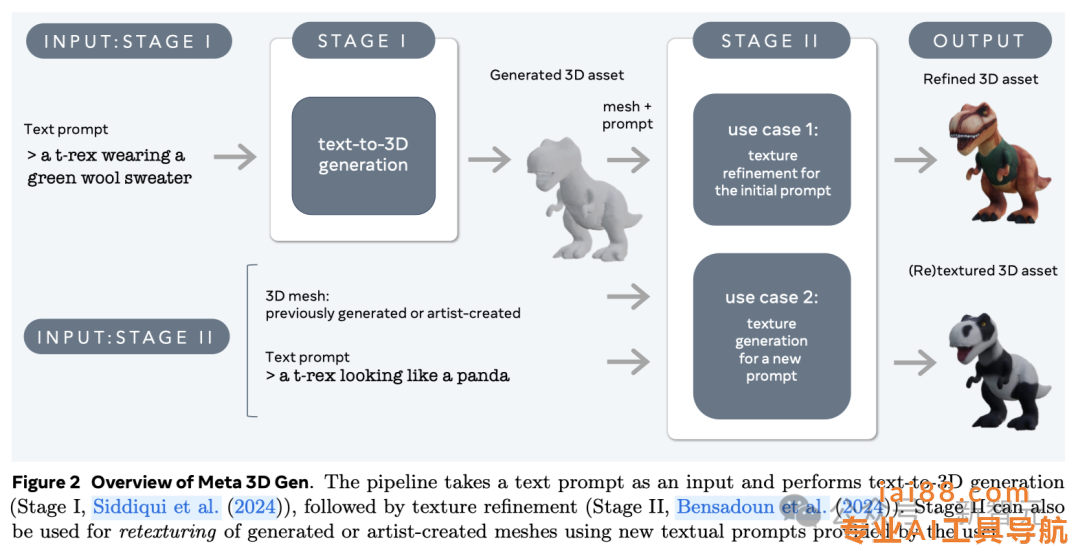

3D Gen的生成主要分为两步,由两个组件分别完成——文本到3D对象生成器AssetGen和文本到纹理生成器TextureGen。

-

第一阶段:3D资产生成。根据用户提供的文本提示,使用3D AssetGen模型创建初始3D资产,即带有纹理和PBR材质图的3D网格,大约花费30s。

-

第二阶段:纹理生成。根据第一阶段生成的3D资产和用户文本提示,使用3D TextureGen模型生成更高质量的纹理和PBR图,大约花费20s。

其中,第二阶段的TextureGen也可以单独拿出来使用。如果有一个之前生成的,或者艺术家自己创作的无纹理3D网格,提供描述外观的文本提示后,模型也能在20s左右的时间中为它从头生成纹理。

AssetGen和TextureGen这两个模型有效地结合了3D对象的三种高度互补的表示:视图空间(物体图像)、体积空间(3D形状和外观)以及UV空间(纹理)。